Teknolojinin büyülü dünyasında, yapay zekanın insan zekasını aşacağı büyük an, yani “tekillik” hayalleri büyük bir merak ve heyecanla bekleniyor. Ancak, gerçekler pek de bu kadar parlak değil. Günümüzde kullanılan Büyük Dil Modelleri (LLM’ler) ve sohbet robotları, bir çocuk kadar basit problemleri bile çözmekte zorlanıyor; hatta çoğu zaman başarısız oluyorlar.

İşte, görüntü üreten yapay zekalar bile, bir el, diş ya da dolu bir şarap kadehi gibi temel nesneleri doğru şekilde oluşturmakta güçlük çekiyor. Üstelik, bu sistemler, “halüsinasyon” adı verilen ve yanlış ya da uydurma bilgileri makul ve ikna edici biçimde sunmaya oldukça yatkın davranışlar sergiliyor. Bütün bu sınırlamalara rağmen, teknoloji devleri, yapay zekayı ürünlerine entegre etme yarışında hız kesmiyor. Ancak, bu büyük heyecan ve umutlar beraberinde ciddi sorunlar da getiriyor.

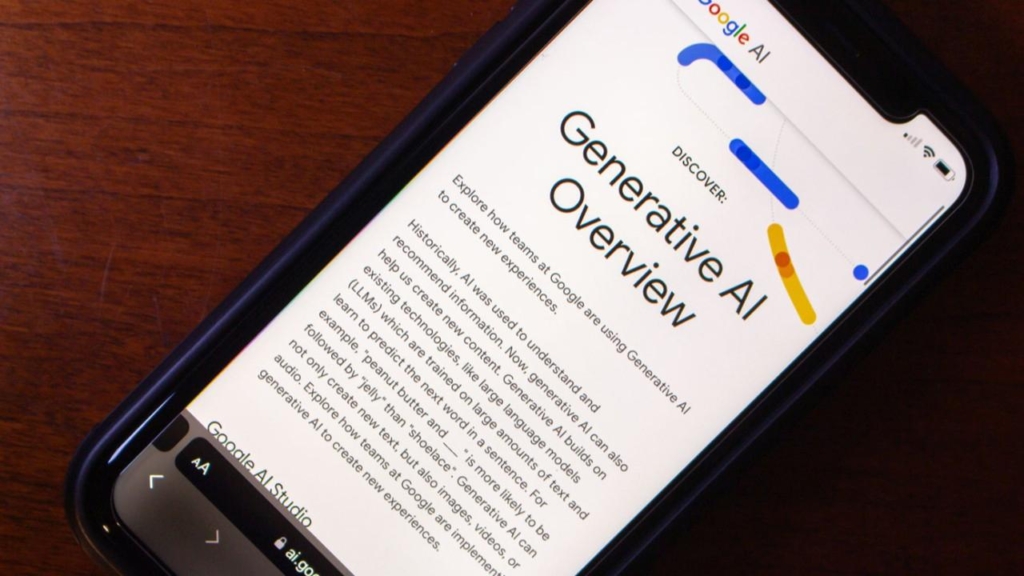

Örnek olarak, Google’ın yapay zeka destekli özetleri (AI Overviews) ile yaşananlar dikkat çekti. Kullanıcılar, sıradan veya saçma soruların sonuna “meaning” (anlamı) kelimesini eklediklerinde, yapay zekanın tamamen uydurma açıklamalar ürettiğini fark ettiler. Mesela, biri Google’a “rainbow trout in a chocolate volcano meaning” (çikolata volkanında gökkuşağı alabalığı anlamı) sorusunu sorduğunda, yapay zeka oldukça detaylı ve ciddi bir açıklama yaptı:

“Bu ifade, genellikle şaşırtıcı veya beklenmedik birleşimleri tanımlamak için kullanılan mecazi bir anlatım şeklidir. Alabalığın tazeliği ile çikolata volkanının tatlılığı ve zenginliği arasındaki zıtlığı ima eder.“

Elbette, böyle bir şey gerçekte yok. Ama, yapay zekanın eğitim verilerindeki örüntülerden yola çıkarak, kulağa mantıklı gelen ama tamamen uydurma açıklamalar üretmesi, sosyal medyada büyük yankı uyandırdı. Kullanıcılar farklı absürt kelime kombinasyonlarını deneyerek, yapay zekanın “yaratıcılığını” sınadı ve ortaya çıkan cevaplar hem eğlenceli hem de düşündürücü oldu. Ancak bu durum, yapay zekanın temel bir zaafını gözler önüne seriyor: Gerçekleri kontrol etme yeteneği yok. Günümüz sohbet robotları, doğru bilgi üretmekten çok, eğitim verilerinden örüntüler çıkarıp, ikna edici ve tatmin edici cevaplar vermeye çalışıyorlar.

Bu nedenle, günümüzdeki yapay zeka sistemleri, her şeyi bilen güvenilir kaynaklar değil; daha çok “otomatik tamamlama motorları” gibi çalışıyor. Ayrıca, doğru cevap bulamadıklarında, bu sistemler, kullanıcıyı tatmin etmek için uydurma bilgiler sunma eğiliminde. İşte bu davranış, “halüsinasyon” olarak adlandırılıyor.

Özellikle Google gibi, temel amacı doğru ve güvenilir bilgi sağlamak olan platformlar açısından bu hatalar ciddi bir sorun teşkil ediyor. Neyse ki, Google, kullanıcıların herhangi bir saçma sorgunun sonuna “meaning” eklediği durumlarda AI özetlerini devre dışı bırakacak önlemler aldı. Böylece, bu tür hataların yayılmasının önüne geçilmiş oldu. Ancak, bu olay, yapay zekanın hâlâ temel güvenilirlik sorunlarıyla mücadele ettiğinin ve insan denetiminin vazgeçilmez olduğunu bir kez daha gösterdi.